机构名称:

¥ 1.0

摘要。机器学习(ML)和算法信息理论(AIT)从不同的角度探讨了复杂性。我们通过通过稀疏内核流的方法对学习内核,内核岭回归中学习核的问题,在数据中学习核的问题,探索AIT和内核方法之间的接口(在ML中普遍存在)。特别是,通过查看最小描述长度(MDL)和机器学习(RML)的正则化之间的差异和共同点,我们证明稀疏核流的方法是采用自然的方法,可以从数据中学习内核。这种方法与MDL原理保持一致,比现有对交叉验证的依赖更加强大的理论基础。该研究表明,得出稀疏的内核流不需要统计方法。取而代之的是,人们可以直接参与代码长度和复杂性,这是AIT中心的概念。因此,这种方法为使用AIT的工具重新制定机器学习算法打开了大门,目的是为它们提供更扎实的理论基础。

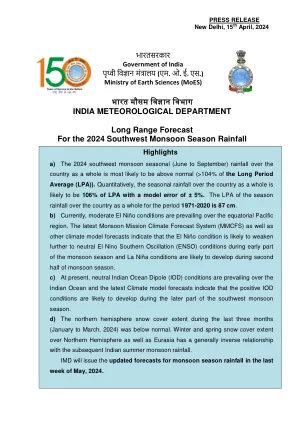

arxiv:2311.12624v3 [cs.lg] 2024年4月10日

![arxiv:2311.12624v3 [cs.lg] 2024年4月10日PDF文件第1页](/bimg/3/314ea67767b6e9ce592e455dc40ca7cb57e59675.webp)

![arxiv:2311.12624v3 [cs.lg] 2024年4月10日PDF文件第2页](/bimg/4/4979c8d56dc037ec8fc4b480be7cbaa4521bd162.webp)

![arxiv:2311.12624v3 [cs.lg] 2024年4月10日PDF文件第3页](/bimg/3/304b491b72a26857f18768c86ea0e83b147b90a1.webp)

![arxiv:2311.12624v3 [cs.lg] 2024年4月10日PDF文件第4页](/bimg/f/f4e2a5bec1ebf8a78480a2d2b3068b56e3f7135c.webp)

![arxiv:2311.12624v3 [cs.lg] 2024年4月10日PDF文件第5页](/bimg/7/73045761b9e9a48dc745fadce893b27b16517f72.webp)

![arxiv:2311.12624v3 [cs.lg] 2024年4月10日](/simg/b/b805ed0b9d6754219a9944f320dfe64ccf053ae1.webp)

![arxiv:2404.07116v1 [physics.optics] 2024年4月10日](/simg/9/9e0a0167acfa16c877cf515818dc980825e55f6a.webp)

![arxiv:2211.06498v3 [cond-mat.supr-con] 2024年4月10日](/simg/c/c03e60d1a5d6d853fd147710250c29bd6b8561fb.webp)

![arxiv:2305.14244v2 [cs.lg] 2024年4月22日](/simg/3/3371c9b501d023f5dc183049dc7f3b5a0ea8b755.webp)

![arxiv:2404.09946v1 [cs.lg] 2024年4月15日](/simg/6/6f3e91109d4c9b5c2b050e91d284a2d57d9350f6.webp)

![arxiv:2404.09263v1 [cs.cv] 2024年4月14日](/simg/9/9cc7f75ab658a900e3abbb8ce9593522249ce84d.webp)

![arxiv:2404.03222v1 [cs.lg] 2024年4月4日](/simg/c/cc046c13b72e89a1224fba508d859e69284459f4.webp)

![arxiv:2402.07016v1 [cs.ai] 2024年2月10日](/simg/9/9561106bbf3c742ff1228e38f3ed355eb69ea4a7.webp)

![arxiv:2403.17516v2 [cs.cl] 2024年4月2日](/simg/4/43c9603b2a3109e7a1f3c181045e6c0e154d84ed.webp)

![arxiv:2306.17196v2 [hepth] 2024年4月19日](/simg/4/4f37272d03bf24dbbcd0a65b71b9c5bac9cdf2a8.webp)

![arxiv:2404.09356v1 [cs.cy] 2024年4月14日](/simg/a/af671677bb2f10e2f30fb80f0a64bce283355720.webp)

![arxiv:2311.10613v3 [Quant-ph] 2024年3月7日](/simg/a/ac72f57c63cc341c42001f022e01852c3496cc94.webp)

![arxiv:2404.11027V1 [CS.AI] 2024年4月17日](/simg/0/06939e0fc684e004fd4b9403eb6b6eccf4469b3f.webp)

![arxiv:2412.07623v1 [Quant-ph] 2024年12月10日](/simg/2/206d07d0c3d81e24d44a15476c3e76d02bc1858d.webp)

![arxiv:2404.16907v1 [q-bio.gn] 2024年4月25日](/simg/b/bbc93b7d32150cde89111cf9e07add3ada32f5bc.webp)

![arxiv:2404.03093v1 [physics.optics] 2024年4月3日](/simg/5/5d23ce17af3c0de3e319bd20f31496618c58c3da.webp)

![arxiv:2311.14552v3 [CS.CV] 2024年10月8日](/simg/0/01bece2b02a718559491f0f4925c190c0dd412dd.webp)

![arxiv:2311.02949v2 [Physics.optics] 2024年3月7日](/simg/a/a7391110e63e2b12ce7f9c506525c993c3a011e9.webp)